☕ Café com Satoshi #57: O Robô Que Dá um Fim aos Influenciadores 😱

Das 5 imagens a seguir, 3 foram produzidas por humanos, e 2 por código.

Duvido que você consiga identificar quais são quais (a resposta tá no final da newsletter).

Hoje você vai aprender:

sobre DALL-E, MidJourney e Stable Diffusion: programas que criam imagens mágicas a partir de um pedido em texto;

a história do cara que jura que viu um desses programas ganhar consciência;

como você trabalha forçosamente para esses robôs, enquanto navega na web;

o que significa o "Vale da Estranheza”;

como influenciadores de entretenimento vão morrer… e o quê os substituirá.

🔓 Pra Quê Servem os Seus CAPTCHAs

Tem uma razão econômica pela qual tantos sites te pedem pra “marcar os quadradinhos que têm um semáforo”.

O CAPTCHA se disfarça como uma forma rápida de distinguir humanos de robôs. Mas também é uma forma barata de fazer humanos trabalharem para robôs.

Anos atrás, CAPTCHAs era usados pelo Google pra digitalizar livros (esquerda, abaixo). Quando já tinham digitalizado tudo, passaram a te pedir pra associar texto e imagem (direita, abaixo). O que ajuda a alimentar seus modelos visuais de aprendizagem de máquina.

Estes modelos se aperfeiçoam em legendar imagens... mas também podem fazer o caminho inverso: ilustrar textos.

💡 Conversando Com Deus Por Uma API

Não é surpresa que o Google lidere o desenvolvimento de modelos de processamento linguístico. Eles têm montanhas de dados pra treinar seus programas, além de capilaridade pra distribuir coisas como CAPTCHAs pela internet inteira.

LaMDA é um modelo de “texto-pra-texto” que ganhou manchetes no mundo todo. Neste tipo de modelo, você escrevia alguma coisa, e o programa completa - seguindo os seus padrões linguísticos, referências conceituais ou instruções explícitas.

Entre as aplicações comerciais, pense, por exemplo:

na Algolia, uma API que autocompleta buscas iniciadas por usuários.

no Grammarly, um plugin que sugere melhorias para seus e-mails enquanto você os escreve.

Um ex-engenheiro do Google, depois de conversar por horas com o LaMDA, jurava que ele tinha desenvolvido consciência.

Em 2020, a Open AI lançou o GPT-3, um modelo de texto-pra-texto que, para muitos, supera o LaMDA.

A OpenAI é uma iniciativa sem fins lucrativos, financiada em larga escala pelo Elon Musk. Dados os investimentos de Musk em “visão computadorizada” (importantes para software de piloto automático, na Tesla, por exemplo), pode se esperar um foco maior da organização em modelos imagéticos do que textuais.

Em 2021, a Open AI anunciou o DALL-E. Batizado em homenagem ao Wall E + Salvador Dali, é um modelo de “texto-pra-imagem”. Você digita algo, e o computador responde pixels ilustrando isso.

Existe uma hipótese famosa no campo da estética computacional - o “Vale Da Estranheza”. Ela diz de que esforços robóticos parecidos demais, mas não idênticos, aos seus equivalente “reais”, provocam repulsa entre observadores humanos.

Um andróide quase perfeito, mas com os olhos levemente desalinhados, é incômodo ao olhar.

O DALL-E definitivamente atravessou o Vale da Estranheza. Por mais de um ano, foi o que tivemos de melhor em geração de imagens com aprendizagem de máquina.

🎨 Dos Textos às Fotos aos Vídeos

A supremacia da Open AI logo foi ameaçada. O pioneirismo tinha lhe permitido ser conservadora na estratégia de distribuição. Usuários pagavam por créditos, e cada “prompt” enviado ao modelo custava um crédito. Vários temas (e.g. mortes) eram proibidos. O acesso era restrito.

Em 2022, 2 competidores do DALL-E despontaram.

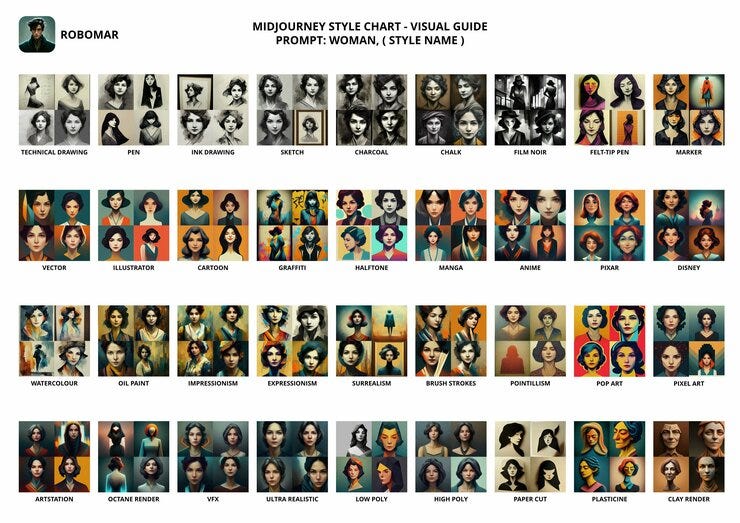

O MidJourney, modelo da empresa de mesmo nome, foi lançado em julho e surpreendeu pelo potencial de cunhar personagens e cenários fantásticos. O robô é acessível pelo Discord, onde responde 4 imagens pra cada “prompt”. É intuitivo pedir pra ele gerar variações do seu resultado favorito.

Ficou tão bom em criar rostos e corpos que o maior desafio passou a ser coibir os fake nudes (veja esse site que “desnuda” qualquer foto que você mandar).

O StableDiffusion (da StabilityAI) foi lançado em agosto. Abriu sua API pro mundo, sem cobrança, e deixa desenvolvedores criarem o que quiserem em cima.

Além de texto, o StableDiffusion também aceita imagens como “prompts”, e pode produzir vídeos como resposta.

Aqui você pode testar alimentá-lo com um rascunho para produzir uma ilustração complexa. Aqui e aqui tem interfaces alternativas. Inspire-se com resultados de outras pessoas aqui.

Mesmo que você ainda não tenha se convencido do potencial do DALL-E, MidJourney e StableDiffusion, imagine alguns anos à frente.

Capas de livros. Concept art para personagens de jogos ou filmes. Storyboards. Prototipagem de roupas. Quantas indústrias criativas não podem ter processos facilitados por modelos de aprendizagem como estes?

Quantas histórias incríveis não vivem nas cabeças de pessoas que não tem os meios para escrevê-las, desenhá-las, filmá-las, ou fotografá-las?

Quantos Steven Spielbergs não podem despontar nas periferias do mundo afora, se o custo de uma câmera não for mais impeditivo pra se fazer cinema? “Pinturas” feitas pelo MidJourney estão ganhando até concursos de arte. Vislumbre o que essas ferramentas não podem destravar de potencial criativo no longo prazo.

🔭 Novos Paradigmas no Entretenimento

1) Nos anos 90, o entretenimento social vinha das revistas.

2) Nos anos 2000, o conteúdo dos seus próprios amigos, nas redes sociais, destronou as notícias da Caras.

3) Nos anos 2010, foram os “amigos profissionais” que roubaram sua atenção. A micro influência se profissionalizou. Gente que passa o tempo todo sendo divertida engaja mais do que as postagens dos seus amigos da vida real, afinal.

4) Mas a era das “Kardashians” tá chegando ao fim. Todo app social tem copiado o TikTok. Vídeos curtíssimos, curados especialmente pra você, entregam mais entretenimento por segundo que qualquer influenciador.

5) O próximo passo dessa evolução são conteúdos não só recomendados, mas gerados por máquina, personalizadamente.

Vai ser cada vez mais difícil pra humanos competirem com fábricas de conteúdo no campo da estética e do puro entretenimento. E, como diz o ditado: “se não pode vencê-las, é melhor se aliar a elas”.

✅ Resposta do Desafio Lá do Começo

Todas as 5 imagens foram geradas por um modelo de aprendizado de máquina - o MidJourney. Nenhuma é de “origem humana”. Os prompts estão aqui. Perdão pela pegadinha 😅

🏜️ Considerações Finais: No Man's Sky

Costumo referenciar um jogo de videogame, sempre que o assunto é criatividade assistida por código.

O jogo é No Man's Sky, de 2016. Consiste numa viagem de exploração interplanetária. Todos os cenários, criaturas, relevos, sons, faunas e floras são procedurais: gerados por computador, a partir de alguns parâmetros originais + randomicidade.

O motor do jogo calculou 18 quintilhões de mundos que podem ser descobertos. 90% dos planetas são inabitáveis. Dos 10% que suportam vida, 90% são ordinários. Só 1% de todos os mundos têm ecossistemas vibrantes.

Nos modos online, cruzar com outro jogador humano ao acaso é quase um milagre estatístico - ainda que você possa construir bases e desenvolver infraestrutura num planeta do qual gostar.

As gravidades são diferentes, o que interfere nos relevos e na anatomia dos animais de cada planeta. Os detalhes do “código” de cada planeta variam até a nível de composição química. Criaturas de um planeta rico num mineral azul tendem a ter pele, penugem ou escamas azuladas também.

O sistema “etiqueta” todo objeto que cria, e designa níveis de afinidade entre todas “etiquetas”. Criaturas animadas são levadas a buscar objetos com que têm afinidade, e a evitar aqueles que desgostam. Há desde as quase domesticáveis, até as que fogem de “humanos”. Os comportamentos tem ciclos. As estações mudam tudo. No jogo dá até pra perceber o efeito acelerado da erosão de longo prazo nos terrenos.

“As afinidades dos animais lhes dão personalidade. Eles têm melhores amigos, como nós. É um marcador num pedaço de código - mas tá lá. Perguntam telepaticamente a seus amigos onde estão indo, e se coordenam sem falar nada” - diz um desenvolvedor

Uma das experiências mais loucas, segundo os pais do game, é assistir às reações de um jogador de primeira viagem. É comum pousar num planeta, topar com uma criatura alienígena, e atirar nela, mesmo que tenham navegado um bocado até encontrá-la.

9 entre 10 vezes, o jogador se sente mal pelo que fez. Não se ganha pontos por matar bichos. Não há moedas de ouro. Ele que escolheu fazer aquilo.

Gosto de lembrar dessa anedota quando escuto críticas pessimistas em relação ao futuro da relação entre humanos e inteligências artificiais. Podemos inimizá-las - mas será que essa é a melhor escolha? Domesticarmos mais uma forma de inteligência, como se não bastassem todas as que já subjugamos na Terra?

🧠 Dicas de Leitura

🛠️ Experimente o MidJourney! (MidJourney)

Basta ter uma conta no Discord e se cadastrar no site do MidJourney. Você entra num chat, manda uma mensagem; o robô responde 4 ilustrações. Fácil e divertido de usar.

🤖 What is it Like to be a Robot? (Rodney Brooks)

Uma viagem sobre os caminhos possíveis pro despertar da consciência numa inteligência artificial.

🌊 The New Normal: The Coming Tsunami of Fakery (Monsieur Grandy)

Um prognóstico sobre o futuro dos fakes num mundo de conteúdo infinitamente barato.