☕ #64: Como Impedir que uma IA Destrua a Humanidade ☄️

O problema do século - e 5 maneiras de atacá-lo.

O século atual é o mais importante de todos.

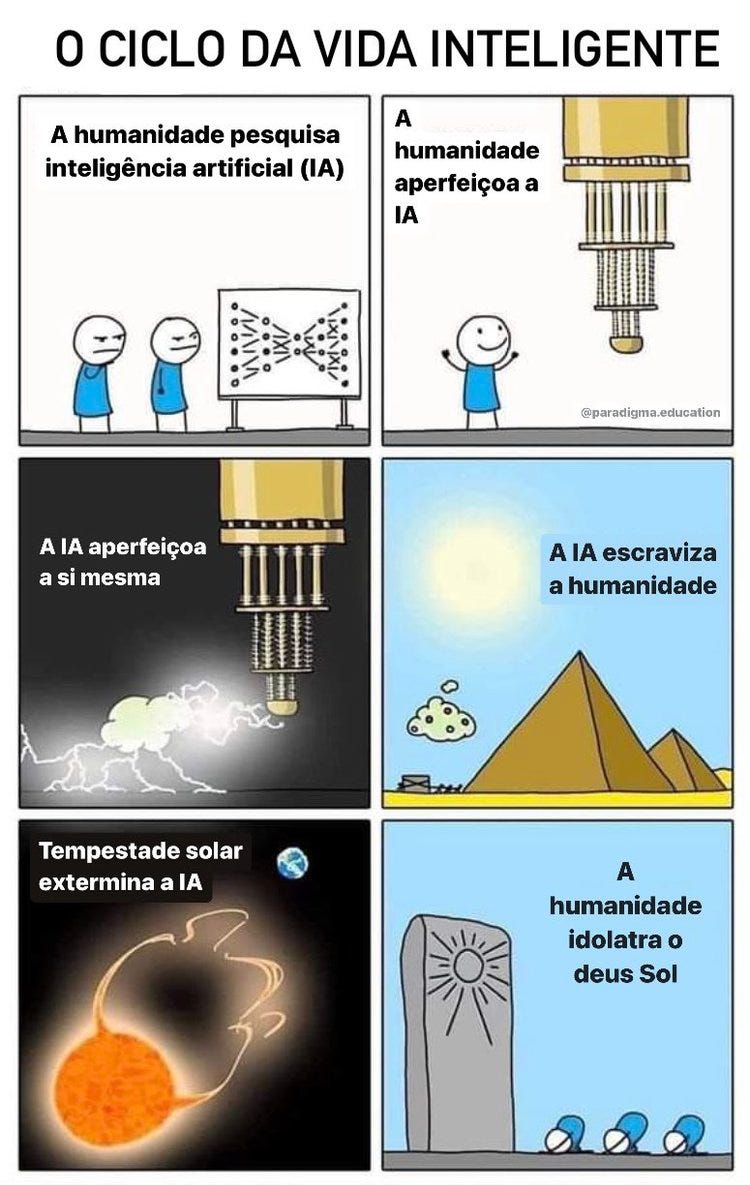

Novas tecnologias farão com que humanos deixem de ser a força motriz da História. Nós só temos uma chance de moldar como essa transição acontecerá.

O nascimento de uma inteligência artificial superpoderosa está mais próximo do que você pensa. Ainda em vida, você vai ver um robô nos subjugar em quase todas as dimensões mensuráveis.

A essa altura, o risco de sermos extintos por uma espécie inorgânica é maior do que os riscos de aquecimento global, guerra nuclear ou impacto de meteoro.

😳 De Que P*rra Você Tá Falando?

A edição #30 dessa newsletter contou a história do engenheiro do Google que jurou ter visto um modelo de texto-pra-texto desenvolver consciência. A edição #57 explicou a revolução dos modelos de texto-pra-imagem. Se você não conhece GPT, MidJourney, DALL-E & cia., cheque estes links antes de prosseguir.

O GPT já dá um belo poeta. O MidJourney já é um baita dum artista. Eles ainda lutam com algumas questões de matemática de nível colegial, e caem em certas pegadinhas… mas, na média, já batem um "aluno medíocre".

O GitHub já integrou o GPT pra ajudar programadores a escreverem seus códigos mais rápido. O Quora adotou ele pros usuários conversarem com o robô, em vez de postarem uma pergunta e ficarem esperando por uma resposta humana. Em 5 anos, quem não estiver usando esses robôs como assistentes pessoais ficará pra trás.

Mais lento, até agora, tem sido o progresso das IAs em aplicações que interajam robustamente com o mundo físico.

Encanadores, eletricistas, azulejistas: as profissões menos automatizadas por inteligências artificiais, até agora, são algumas das que mais requerem interação física.

Isso acontece primariamente por barreiras regulatórias e relações públicas: mesmo que um carro autônomo sofra menos acidentes que os dirigidos por humanos, pode não ser bom o suficiente. A barra das máquinas é mais alta. Em parte porque, quando acidentes acontecem, as circunstâncias são bizarras demais.

Esse tópico aparece em incontáveis ficções científicas. Qualquer que seja o futuro em que cheguemos, em retrospecto, as pessoas dirão: “olha, esse conto obscuro dos anos 70 previu com exatidão!”. O problema é que ainda não sabemos qual 😉

🧭 "Alinhamento das IAs": o Problema do Século?

A proliferação das IAs suscita questões polêmicas. Existem 2 tipos de pessoas preocupadas. Uma das pontas do espectro é o campo da "Ética em IA”; o outro é o do “Alinhamento das IAs”.

O primeiro lida com segurança imediata: como "barrar o GPT de falar coisas racistas". Ou “impedir o DALL-E de gerar fake porn” das pessoas.

O segundo, "Alinhamento das IAs", aborda a questão de longo prazo: como prevenir que a IA se torne superinteligente e destrua a humanidade.

Eliezer Yudkowsky, o "profeta do alinhamento das IAs", discute o tema há décadas. Ele mantém o blog Less Wrong, e já escreveu uma fanfic racionalista de Harry Potter com +500 páginas aclamada no mundo inteiro. Recentemente, assumiu uma postura completamente apocalíptica.

Hoje, aponta uma probabilidade de >99% de uma IA nos matar. Diz que o debate quase não importa; é tarde demais. Trata-se, acima de tudo, sobre ser aniquilado com o máximo de dignidade possível.

Novos-entrantes na área costumam ser mais otimistas. Talvez, daqui 20 anos, eles se tornem pessimistas como Yudkowsky. Ou talvez nós nem estejamos vivos até lá.

📝 5 Jeitos de “Tentar Policiar as IAs"

Pessoas como Yudkowsky já bolaram diversas maneiras de minimizar os riscos causados por IAs. O problema geral é que, qualquer que seja a medida, se a IA for inteligente o suficiente, vai empreitar uma contramedida que nosso cérebro primata não consegue nem apreender.

Sendo assim… como as empresas que lideram o desenvolvimento das IAs devem se policiar? Simplesmente seguem evoluindo seus modelos até que um se mostre… incontrolável?

O método mais legal da lista a seguir é o último. Comecemos pelos mais simples.

1 - “Tirar da Tomada”

Se humanos tiverem controle físico do hardware no qual a IA “vive", podem tirá-lo da tomada se as coisas saírem do rumo. A objeção padrão, aqui, é a de que, quando chegar a hora… a IA vai ter “acessado a internet", feito cópias de si mesmo, e as hospedado em servidores espalhados pelo mundo.

2 - “Sandboxing”

Já assistiu “O Show de Truman”? A ideia aqui é parecida. Desenvolver novas IAs somente dentro de uma realidade simulada. O comportamento pode ser estudado antes de uma IA ser “liberada” no mundo. O problema é que ela pode fingir se comportar, mas só revelar intenções perversas quando for definitivamente “graduada”. Isso nos leva à próxima abordagem.

3 - "Interpretabilidade”

Qualquer um consegue fazer uma IA mentir: basta entrar no ChatGPT, dizer algumas falácias pro robô, e instruir ele a entrar num “jogo de enganação”. Ele vai continuar o besteirol. Mas este paper mostra que, nesses casos, olhando-se para as camadas internas do modelo, dá pra encontrar onde ele guarda a representação daquilo que julga ser “verdade" - informação que sobrescreve na hora de responder “uma mentira”.

Em suma, tem um jeito de “detectar quando a IA não tá sendo honesta”. A ideia da “Interpretabilidade” é que, interpretando o processo pelo qual a IA chega em suas conclusões, podemos descobrir quando estiver tentando nos ludibriar sobre algo.

(é com interpretabilidade que trabalha a Antrophic, startup de AI que levantou U$500M de Sam Bankman-Fried)

4 - Uma Função Objetiva

Conforme nos damos conta de que qualquer “medida de segurança” pode ser, mais cedo ou mais tarde, “driblada” pelas IAs, uma coisa fica clara. Não adianta jogar contra. É preciso estar no mesmo time. É daí que vem o nome “Alinhamento das IAs”: a ideia de que devemos “alinhar nossos incentivos e vontades”.

A abordagem da “função objetiva” sugere que cheguemos a uma formalização matemática precisa dos valores humanos. Aquilo que queremos que as IAs maximizem, e que coincida com nosso bem-estar.

De certo modo, isso foi o que Asimov tentou fazer com suas Três Leis da Robótica. O problema é - quem leu suas histórias sabe - a miríade de situações em que elas não bastam pra evitar um desastre.

5 - “Vontade Extrapolada Coerente”

Se for infactível denotar matematicamente os “valores humanos” para os robôs… por que não podemos tratá-los como só mais um problema de machine learning?

Uma ideia é alimentar uma IA com todas as fábulas, contos infantis e charges de jornal de domingo - todos os exemplos que temos daquilo que pensamos ser bom ou mau; certo ou errado - e mandar ela fazer sua mágica. Generalizar esses exemplos o mais longe que puder.

Uma objeção que surge é: como sabemos que nossos valores atuais são “os certos”? Teria sido terrível treinar uma IA sobre os valores consensuais da sociedade no ano de 1700, não é mesmo? O passado é cheio de coisas das quais não nos orgulhamos.

A versão mais promissora dessa abordagem é a “Vontade Extrapolada Coerente”. Basicamente dizer à IA: “Toma esse monte de informação sobre a moralidade humana no ano 2023. Agora, simule-nos em um seminário de discussão por 10.000 anos, tentando aprimorar essas intuições, e, onde quer que você chegue: estes devem ser os seus valores hoje".

Cientistas contribuidores do Metaculus preveem que atingiremos a “Inteligência Artificial Geral” em abril de 2040. Note como o consenso era 2100+ antes de 2022.

🌎 IAs & Geopolítica

Alguns meses atrás, o governo Biden decidiu restringir exportações de placas gráficas (GPUs) de ponta para a China. Os americanos temem que Pequim treine livremente IAs gigantescas. O status de Taiwan é peça-chave no imbróglio - assim como a capacidade de a China desenvolver uma indústria de semicondutores autossuficiente.

O Metaculus, um site de previsões coletivas, projeta uma superinteligência artificial em 2040. Eliezer Yudkowsky aposta na segunda metade do século. Em mesas de bar, já tem gente prevendo um apocalipse robô antes do próximo Natal.

Já diria a Lei de Amara: “costumamos superestimar o impacto da tecnologia no curto prazo, e subestimá-lo no longo prazo".

A verdade é que estamos em uma bifurcação da história.

A língua nativa da primeira superinteligência artificial vai ser inglês ou mandarim? Quem - e como - terá definido “seus princípios”? Quem a policiará?

Será que o primeiro país que ver uma AGI vai sair contando pra todo mundo? Será que múltiplas superinteligências emergirão em lugares diferentes ao mesmo tempo? Competirão entre si? Se aliarão aos humanos, ou nos esmagarão num piscar de olhos?

Quando e como saberemos se já não estão entre nós?

🧠 Dicas de Leitura

🕰️ The Most Important Century (Holden Karnofsky)

Série de um filantropo famoso sobre o quão crítico é o “alinhamento das IAs”.

🌊 Before the Flood (Samuel Hammond)

Ruminações importantes sobre o impacto das inteligências artificiais (IAs) na política.

👮♀️ My AI Safety Lecture for Effective Altruism (Scott Aaronson)

Confissões de um cara que desenvolve meios de se “deixar uma marca d`água” nos textos escritos por robôs como o GPT.

🌌 Galactic Scale Energy (Tom Murphy)

Uma exploração dos limites termodinâmicos para o crescimento da economia na Terra.